·目前具身智能领域正处在类似于从GPT-1到GPT-2的过渡阶段,连最基础的物理世界的数据都还十分匮乏。遥操作方式获取的数据成本过于高昂且采集效率低,导致行业内很难获取。除了缺乏高质量数据,徐良威认为,具身智能数据服务行业内面临的首要难题是缺乏统一的数据集定义标准。

过去的一年,具身智能、人形机器人引发的关注与日俱增,但喧嚣过后,这一行业的发展也正面临着艰巨的挑战,其中训练具身智能大模型所需要的高质量数据在哪的问题成为眼下行业的一大共同的困扰。

日前,上海机器人初创公司智元机器人正式开源百万真机数据集AgiBot World使得数据缺乏问题再次被提起。智元机器人联合创始人、首席技术官彭志辉(网名为“稚晖君”)表示,在具身智能领域,真机数据的采集成本和门槛非常高,此次开源希望众多科研团队基于真实数据进行具身智能算法的训练,加速技术创新和产品应用。但在业内人士看来,“百万条真机数据量”对于行业来说只是杯水车薪,“只能训练一个动作的泛化,譬如分拣,对实现理想状态中的具身智能还远不够。”

除了数据缺乏的困扰之外,已有数据的标准化也是一个待解难题。

连最基础的数据都缺乏

不同于语言大模型的训练得益于互联网上海量的数据,具身智能“大脑”的训练则需要更多来自物理世界即真实世界动态环境中的交互数据,如何解决物理世界数据匮乏问题,成为眼下人形机器人技术演进路上最大的难题。

人形机器人创业企业之一——银河通用的创始人兼CTO、北京大学助理教授王鹤此前在不同场合多次提及具身智能领域面临数据集短缺的难题。王鹤认为,通用机器人背后的技术一定是具身大模型,要用数据驱动基础机器人大模型,让机器人能够有极高的泛化性和跨行业应用能力。但现有数据量不足以支持通用机器人的发展。

泛化性是指模型经过训练后,能够将一项行为应用到陌生的应用场景中的能力,在陌生场景中能自主识别任务并采取行动。国家地方共建人形机器人创新中心(以下简称“国地中心”)相关数据负责人在接受澎湃科技(www.thepaper.cn)采访时表示,行业内对于机器人泛化数据的获取始终是一大难题,现阶段,特斯拉的Optimus仍需要人为远程操作来帮助机器人完成任务,还不具备泛化能力。

国家地方共建人形机器人创新中心具身智能数据看板,澎湃科技记者拍摄。

北京航空航天大学机器人研究所名誉所长王田苗此前在接受澎湃科技采访时也指出,数据的匮乏让人形机器人很难具备泛化性。当前,机器人任务泛化、感知泛化和运动操作的三个泛化数据很难获取,比如让机器人叠衣服、骑自行车等这些数据很难得到。

王鹤团队从2023年开始探索大规模的灵巧手数据合成和大规模的泛化,2024年合成了10亿规模的数据体量,用于训练机器人的灵巧手。

总部位于深圳的一家向具身智能机器人提供基础场景数据和解决方案的创业公司艾欧智能联合创始人徐良威告诉澎湃科技,经过一年多对于机器人技术路径的探索发现,“只有通过海量数据训练才能够真正地通向具身智能”已经成为行业共识,通过仿真数据实现智能的可能性远远小于使用真实数据。然而,目前具身智能领域正处在类似于从GPT-1到GPT-2的过渡阶段,连最基础的物理世界的数据都还十分匮乏。

在徐良威看来,对于训练具身智能泛化能力来说,AgiBot World这种百万量级的数据集虽然已经取得明显的进步,但只是“杯水车薪,洒洒水而已”,达到理想的效果需要更大量的数据。

高质量数据获取采集成本过于昂贵

澎湃科技记者了解到,在具身智能领域实践中发展出四种具身智能采集训练数据:第一种是遥操作机器人数据,即需要一位人工数据采集员戴着遥操作手套,手把手示教,获取真机操作数据。通过这种方式获取的数据质量最高,但成本昂贵。第二种是仿真合成数据,在虚拟的3D仿真环境里从无到有地积累训练数据,这类训练数据以生成数据为主,与真实世界仍有较大差异。第三种是通过人类动作捕捉数据,也称为动作捕捉或动作追踪数据,是通过传感器、摄像头或其他设备,精确记录和分析人体运动的技术。这类方式获取的数据质量较高,但通过人类动作捕捉获取的数据,与机器人能否适配仍存在一定差异,需要后期继续做构型对齐相关工作。第四种数据来源是通过互联网获取人类动作视频或图像数据。这类方式的特点是能获得海量数据,但都是单一模态、非结构化且无标注的二维图像或视频信息,质量很差。

国地中心数据负责人指出,目前行业内最匮乏的是通过遥操作方式获取的高质量数据,仿真合成类数据获取成本低,但仍需要弥合仿真与现实世界的差距。然而,遥操作方式获取的数据成本过于高昂且采集效率低,导致行业内很难获取。

数据训练员穿上特制的动作捕捉服装训练人形机器人捕捉数据

“一台遥操设备投入约35万元,再加上人工数据采集员的成本,每人每天大约采集500条数据,人工成本至少需要300元,即便长期投入也无法保证成功。”国地中心数据负责人估算,特斯拉的人形机器人Optimus至少需要数百万小时的数据才能完全准备好在特斯拉工厂工作,这期间可能需要至少5亿美元的数据采集成本。

上述国地中心数据负责人向澎湃科技透露,即便银河通用专注于强化机器人大脑模型,强调仿真合成数据的使用,但仍面临一定挑战。“在仿真环境中参数看似正确,但在物理世界中,即使是微小的偏差也会导致完全不同的结果。比如,人形机器人执行蹲下起身这类动作时,不同机器人可能会有不同表现,电机参数任何微小变化可能会导致机器人出现完全不同的行为,很难控制。”

由于泛化数据采集成本高、获取难度大,国地中心数据负责人透露,现阶段行业内大部分按照1:9或者1:10的数据比例训练机器人,即一条遥操作机器人数据配以9条或者10条仿真合成数据,但这个比例目前还没有定论。

缺乏统一标准的数据集

徐良威认为,另一个关键问题是如何实现高效的数据采集。虽然通过人工操作机器人可以获取高质量的数据,但这种方式的效率极低。徐良威称,智元对外称一周可采集50万条数据,综合一年数据量也不过只能达到千万量级,这对具身智能训练效率非常低,难以提速。

除了缺乏高质量数据,徐良威认为,具身智能数据服务行业内面临的首要难题是缺乏统一的数据集定义标准。尽管海外有Google这类科技巨头已开源部分数据集,国内也有智元机器人开源百万条真机数据集等,但不同公司开放的数据集格式能否兼容、能否保持数据质量的一致性很难说。

“北京和上海的开源数据集能否兼容、数据格式是否一致,以及数据托管的方式有哪些不同,这些还有待出台统一的数据标准。”徐良威说,目前国内众多机器人公司正处于“百花齐放”的状态,在数据管理上也各自为政,这导致公司之间沟通成本非常高。

在数据处理上,目前行业内也缺少统一的数据处理标准。“不同公司、机构或平台对处理数据的方法不一,机器人如果要有效利用这些数据,还需进一步处理。”徐良威说,每个团队或公司可能都需要从头开始处理标注数据,这会浪费大量时间和资源,且无法保证训练结果的通用性。

近期,国家地方共建具身智能机器人创新中心牵头立项的《人工智能具身智能数据采集规范》工信部行业标准,规范了具身智能数据集采集的格式,使不同公司采集的数据可以互相共享开源,加速模型“涌现”,在徐良威看来,对从业者来说无疑是一个积极的信号。

2025年会出现更多的数据采集训练场

世界模型的出现似乎给人形机器人带来一些新的希望。去年12月,李飞飞的世界模型开启了从数字世界向物理世界的跨越征程,实现了从一维数字智能向三维空间智能的重大转变。2025年1月6日,英伟达创始人兼首席执行官黄仁勋在2025CES(国际消费类电子产品展览会)期间,推出了涵盖生成世界基础模型的Cosmos世界基础模型平台,旨在加速自动驾驶汽车、机器人等物理AI系统开发。黄仁勋认为,“机器人的ChatGPT时刻即将到来。与大语言模型一样,世界基础模型对于推进机器人和自动驾驶汽车的开发至关重要。”

徐良威称,这一类世界模型为通用智能提供空间、时间、物理、语义等各方面的模型表征。理论上来说,一方面,世界模型的成功使得机器人“理解世界”具备可能性;另一方面,世界模型能够在各维度下生成符合世界规律的数据,有潜力成为机器人合成数据的新范式。不过,虽然世界已经有一些阶段性的成果推出,但真正在机器人上应用,直至能够商业落地也还需要进一步发展。

数据缺乏在成为业内共识的同时,各方也在采取解决方案。2024年8月,特斯拉对外高薪招募“数据采集员”;2024年12月27日,北京国地共建具身智能机器人创新数据采集基地亮相。

据了解,从2024年下半年开始,位于上海张江的国家地方共建人形机器人创新中心也在搭建基于自己平台的数据采集训练场,目前,训练场的场地搭建工作以及数据采集机器人设备也基本到位,2025年计划招聘一些数据采集员来配合遥操作数据采集。2025年预期量产机器人的数量会上升,随之带来的数据采集量也会大幅增长,在数据采集成本方面也会下降。“今后可能会有一批便携式数据采集工具出现,这样会进一步降低数据采集成本。”相关人士透露。

在徐良威看来,北京、上海相继表示要共建具身智能机器人创新数据采集基地和搭建实训、模拟应用场景建设,核心价值远不止数据采集本身,更重要的是能够集中资源、缩短数据积累的时间,也相应地缩短了具身智能市场准入时间。他预测,2025年不同地区会加快建设数据采集训练场,以便从0到1的过程中尽快实现机器人的落地应用,此外数据采集方式将更加多样化。

·AI如果想要真正赋能全人类,让每个人都能够用得上、用得起大模型和通用人工智能,那么高效性显然是一个非常重要的命题。

·我们认为智能革命显然也要走过一条类似于信息革命的阶段,不断去提高能力密度,降低计算成本,让大模型得以更加普惠。

“DeepSeek R1的开源,让全球的人能够意识到深度思考的能力。这相当于让整个人工智能领域再次迎来了类似于2023年初ChatGPT的时刻,让每个人感受到大模型的能力又往前迈进了一大步。但同时,我们也需要合理地评估DeepSeek本身的重要意义。”清华大学长聘副教授刘知远日前在参与由中国计算机学会青年计算机科技论坛(CCF Young Computer Scientists & Engineers Forum,YOCSEF)策划的直播活动中表示,这场直播的主题为“夜话DeepSeek:技术原理与未来方向”,共同参与话题讨论的还有复旦大学教授邱锡鹏、清华大学教授翟季冬等。

直播截图

在这场直播中,刘知远分析了DeepSeek成功出圈带来的启示,并分析了大模型技术未来发展的趋势。刘知远认为,DeepSeek V3展示了如何用十分之一甚至更少的成本完成达到GPT-4和GPT-4o水平的能力,此外DeepSeek R1的出圈也证明了OpenAI犯了“傲慢之罪”——它不开源,不公开技术细节,且定价过高。

以下为刘知远在直播中的观点实录,经本人同意发表:

今天我将从宏观角度为大家介绍DeepSeek R1所代表的大规模强化学习技术,及其基本原理。同时,我们也会探讨为什么DeepSeek R1能够引起如此多的关注。

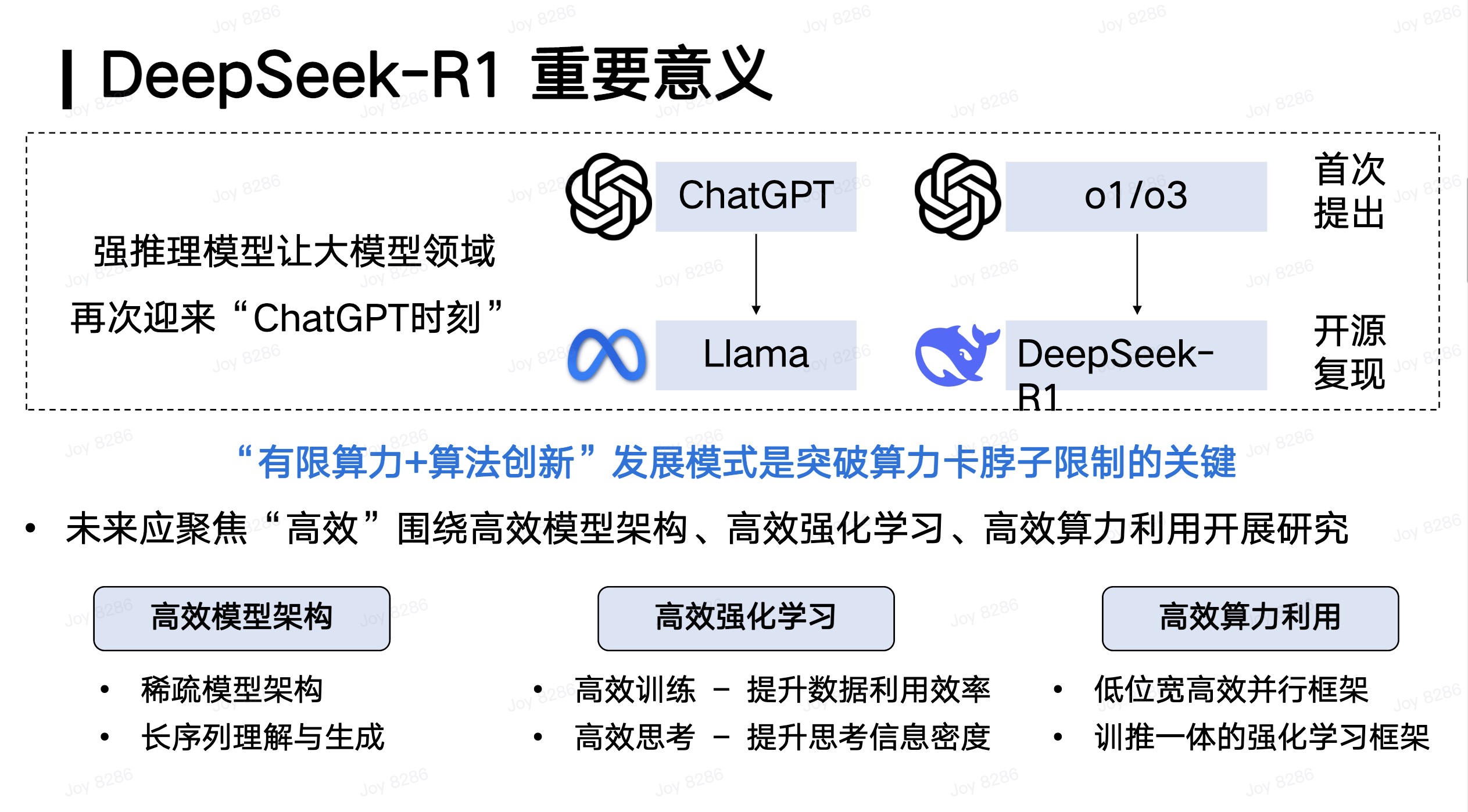

首先,我们来看DeepSeek最近发布的R1模型,它具有非常重要的价值。这种价值主要体现在DeepSeek R1能够完美复现OpenAI o1的深度推理能力。

因为OpenAI o1本身并没有提供关于其实现细节的任何信息,OpenAI o1相当于引爆了一个原子弹,但没有告诉大家秘方。而我们需要从头开始,自己去寻找如何复现这种能力的方法。DeepSeek可能是全球首个能够通过纯粹的强化学习技术复现OpenAI o1能力的团队,并且他们通过开源并发布相对详细的介绍,为行业做出了重要贡献。

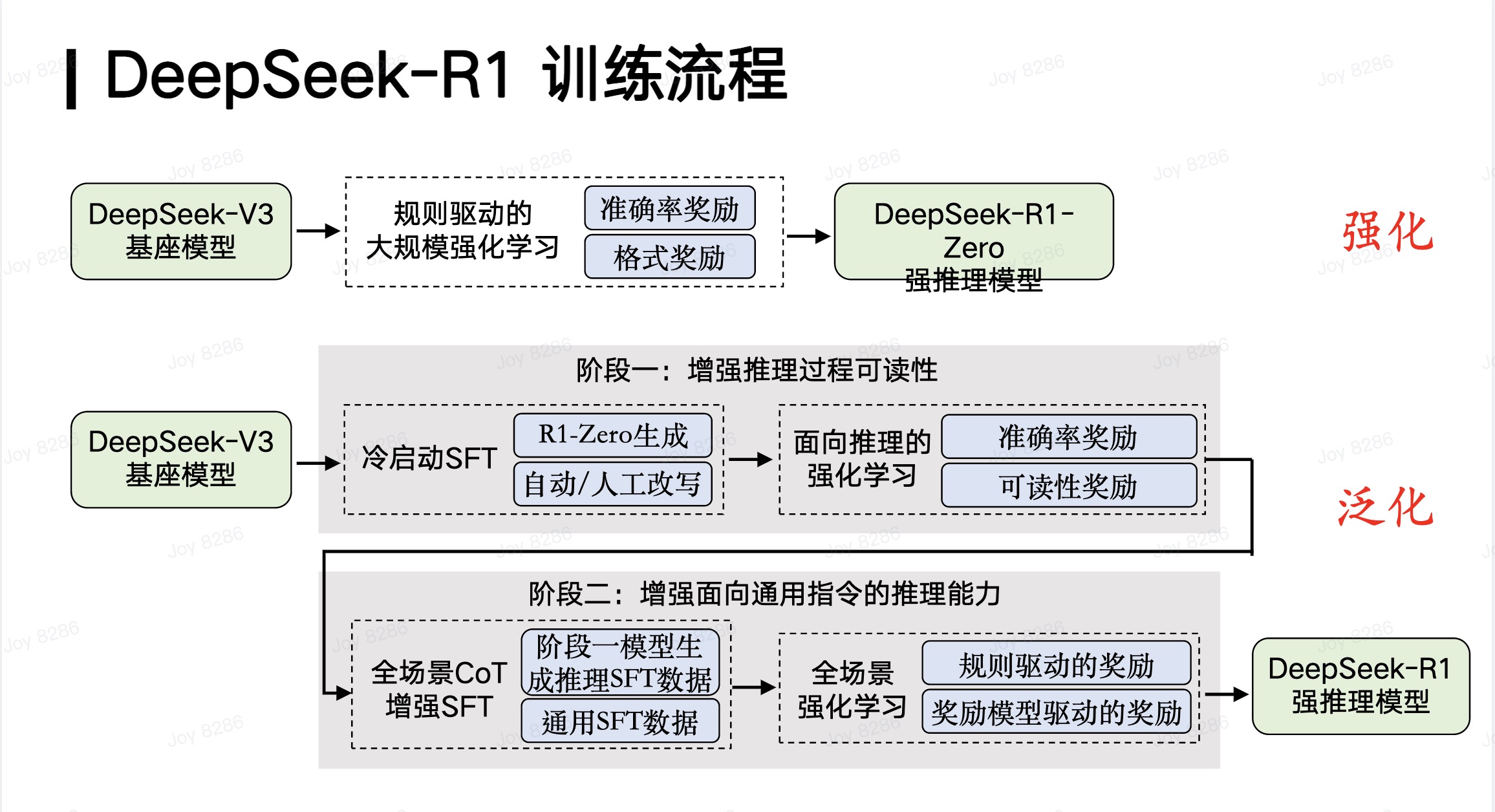

我们可以大致总结了DeepSeek R1的整个训练流程,它有两个非常重要的亮点或价值。首先,DeepSeek R1创造性地基于DeepSeek V3基座模型,通过大规模强化学习技术,得到了一个纯粹通过强化学习增强的强推理模型,即DeepSeek-R1-Zero。这具有非常重要的价值,因为在历史上几乎没有团队能够成功地将强化学习技术很好地应用于大规模模型上,并实现大规模训练。DeepSeek能够实现大规模强化学习的一个重要技术特点是其采用了基于规则(rule-based)的方法,确保强化学习可以规模化,并实现面向强化学习的扩展(Scaling),这是它的第一个贡献。

DeepSeek R1的第二个重要贡献在于其强化学习技术不仅局限于数学、算法代码等容易提供奖励信号的领域,还能创造性地将强化学习带来的强推理能力泛化到其他领域。这也是用户在实际使用DeepSeek R1进行写作等任务时,能够感受到其强大的深度思考能力的原因。

这种泛化能力的实现分为两个阶段。首先,基于DeepSeek V3基座模型,通过增强推理过程的可读性,生成了带有深度推理能力的SFT(Supervised Fine-Tuning,监督微调)数据。这种数据结合了深度推理能力和传统通用SFT数据,用于微调大模型。随后,进一步通过强化学习训练,得到了具有强大泛化能力的强推理模型,即DeepSeek R1。

因此,DeepSeek R1的重要贡献体现在两个方面:一是通过规则驱动的方法实现了大规模强化学习;二是通过深度推理 SFT数据与通用SFT数据的混合微调,实现了推理能力的跨任务泛化。这使得DeepSeek R1能够成功复现OpenAI o1的推理水平。

所以,我们其实应该非常重视DeepSeek R1。它由于开源,让全球的人能够意识到深度思考的能力,这相当于让整个人工智能领域再次迎来了类似于2023年初ChatGPT的时刻,让每个人感受到大模型的能力又往前迈进了一大步。但同时,我们也需要合理地评估DeepSeek本身的重要意义。

如果说2023年初OpenAI发布的ChatGPT让全球看到了大模型非常重要的价值,那么这一次的强推理能力其实也是OpenAI在2024年9月发布的o1率先实现的。而DeepSeek R1,我们认为它在历史上更像是2023年Meta的LLaMA。它能够通过开源复现,并且把这些事情全部公开给全球,让大家能够快速地建立起相关能力,这是我们对DeepSeek R1及其重要意义的一个准确认识。

当然,为什么说DeepSeek R1能够取得如此全球性的成功呢?我们认为这与OpenAI采用的一些策略有非常大的关系。OpenAI 在发布o1之后,首先选择不开源,其次将o1深度思考的过程隐藏起来,第三是o1本身采用了非常高的收费。这使得o1无法在全球范围内让尽可能多的人普惠地感受到深度思考所带来的震撼。

而DeepSeek R1则像2023年初OpenAI的ChatGPT一样,让所有人真正感受到了这种震撼,这是DeepSeek R1出圈的非常重要的原因。如果我们进一步将DeepSeek发布的R1和之前的V3结合起来考虑,那么它的意义在于:在非常有限的算力资源支持下,通过强大的算法创新,突破了算力瓶颈,让我们看到即使在有限的算力下,也能做出具有全球意义的领先成果。

这件事对中国AI的发展具有非常重要的意义。当然,我们也应该看到,AI如果想要真正赋能全人类,让每个人都能够用得上、用得起大模型和通用人工智能,那么高效性显然是一个非常重要的命题。

而在这个方面,我们其实有非常多的话题可以去讨论。除了刚才我和邱锡鹏老师提到的强化学习本身需要在未来探索更加高效的方案之外,我们还需要研究出更加高效的模型架构。例如,V3所采用的MoE架构,未来应该也会有许多其他相关的高效架构方案。进一步地,国浩和翟季冬老师稍后也会介绍高效的算力应用等话题。

这其实也是DeepSeek V3和R1带给我们的另一个非常重要的启示。我们也会认为,整个人工智能的发展在未来追求高效性是我们内在的一个使命和需求。

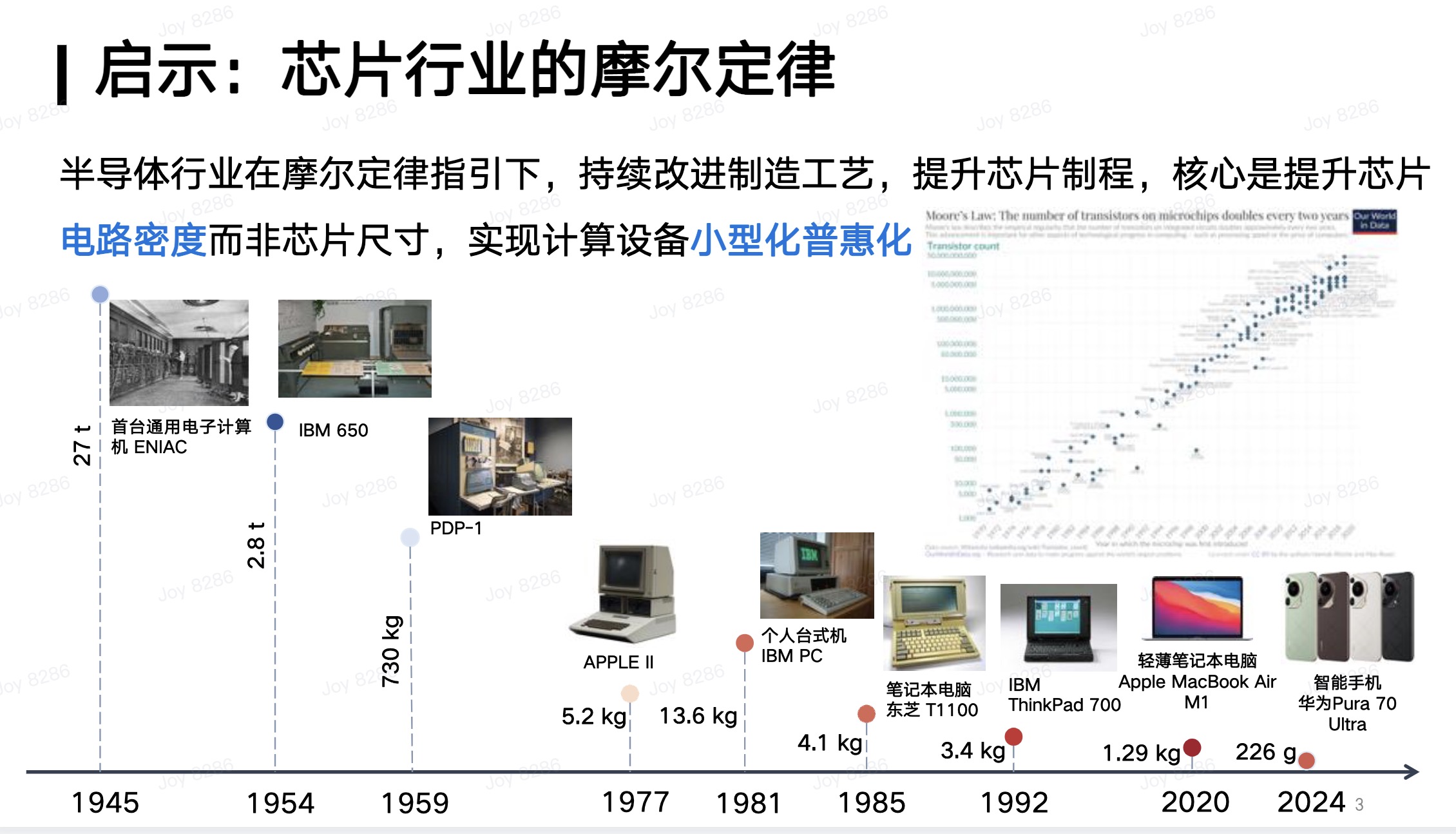

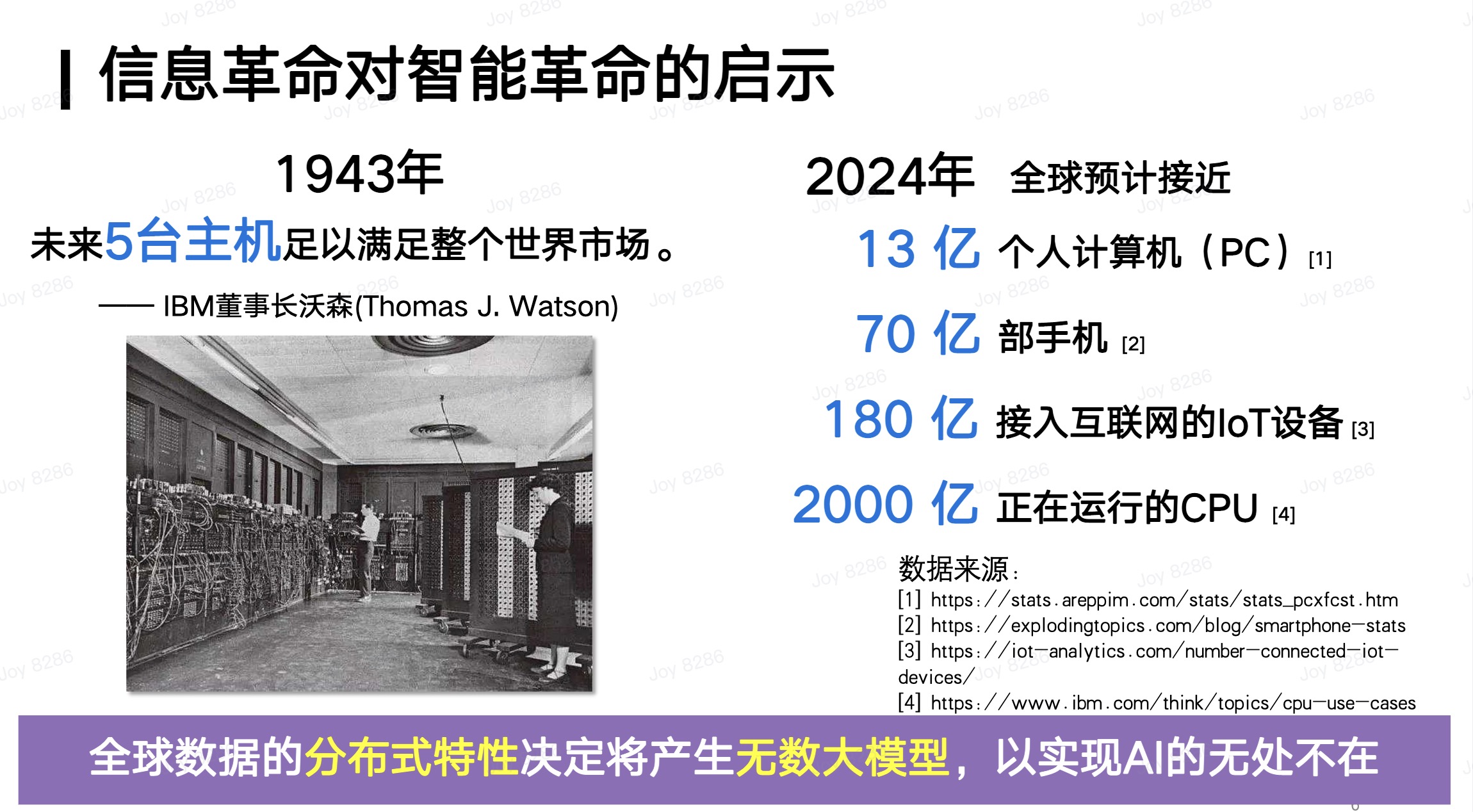

从这个方面,我想适当展开一点来介绍。我们会看到上一次所谓的科技革命,也就是信息革命,其非常重要的内核实际上是计算芯片的发展。在过去80年时间里,计算机从最初需要一个屋子才能装得下的规模,发展到如今每个人手边都有的手机、PC,以及各种各样的计算设备,都可以在非常小的设备上完成非常强大的计算能力。

所有这一切,其实都源于芯片行业在摩尔定律的指引下,不断推进芯片制程,提升芯片电路密度,从而实现计算设备的小型化和普惠化,推动算力的普及。这显然是我们未来追求高效性的一个非常重要的内在需求。

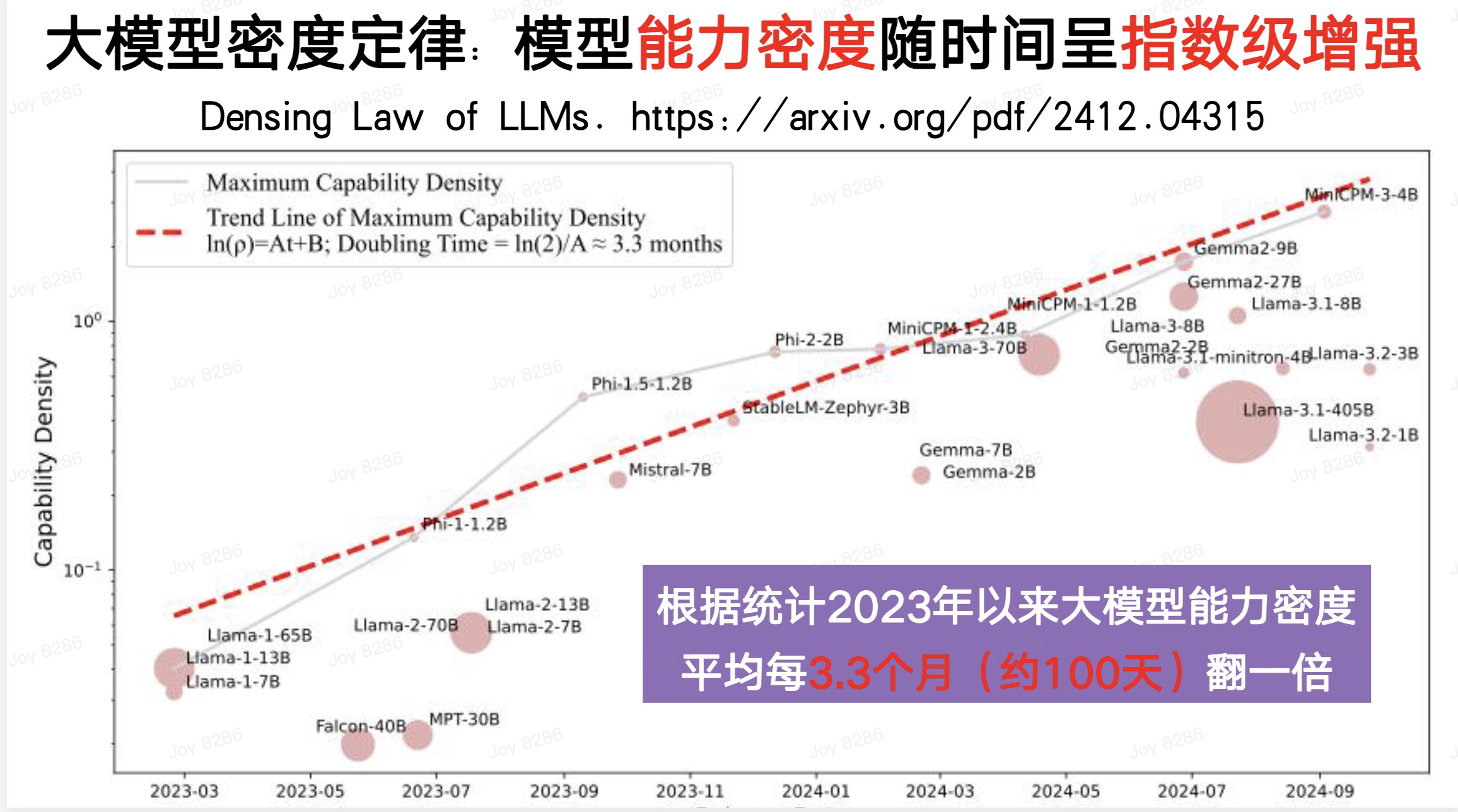

这也是为什么我们在去年特别强调要发展大模型的能力密度。实际上,过去几年我们也能看到类似摩尔定律的现象:大模型的能力密度正以时间的指数级增强。从2023年以来,大模型的能力密度大约每100天翻一倍,也就是说,每过100天,我们只需要一半的算力和一半的参数就能实现相同的能力。

因此,我们相信,面向未来,我们应该不断追求更高的能力密度,努力以更低的成本——包括训练成本和计算成本——来实现大模型的高效发展。 从这一点来看,我们显然可以看到,如果按照能力密度的发展趋势,我们完全可以实现每100天用一半的算力和一半的参数,达到相同的模型能力。而推动这件事情,应当是我们未来发展的使命。

所以,如果我们对标上一个科技革命——也就是信息革命,显然对我们即将到来的智能革命有着非常重要的启示。实际上,在信息革命刚刚开始的时候,IBM的创始人沃森曾认为,世界上不需要超过五台主机就可以满足全世界的计算需求。但到了今天,我们可以看到全球有数十亿、上百亿的计算设备在服务于全人类的社会。

因此,我们认为智能革命显然也要走过一条类似于信息革命的阶段,不断去提高能力密度,降低计算成本,让大模型得以更加普惠。所以,我们会认为AI时代的这些核心引擎,包括电力、算力以及大模型所代表的智力,这种密度定律应该是普遍存在的。我们需要不断地通过高质量、可持续的方式去实现大模型的普惠,这应该是我们未来的发展方向。

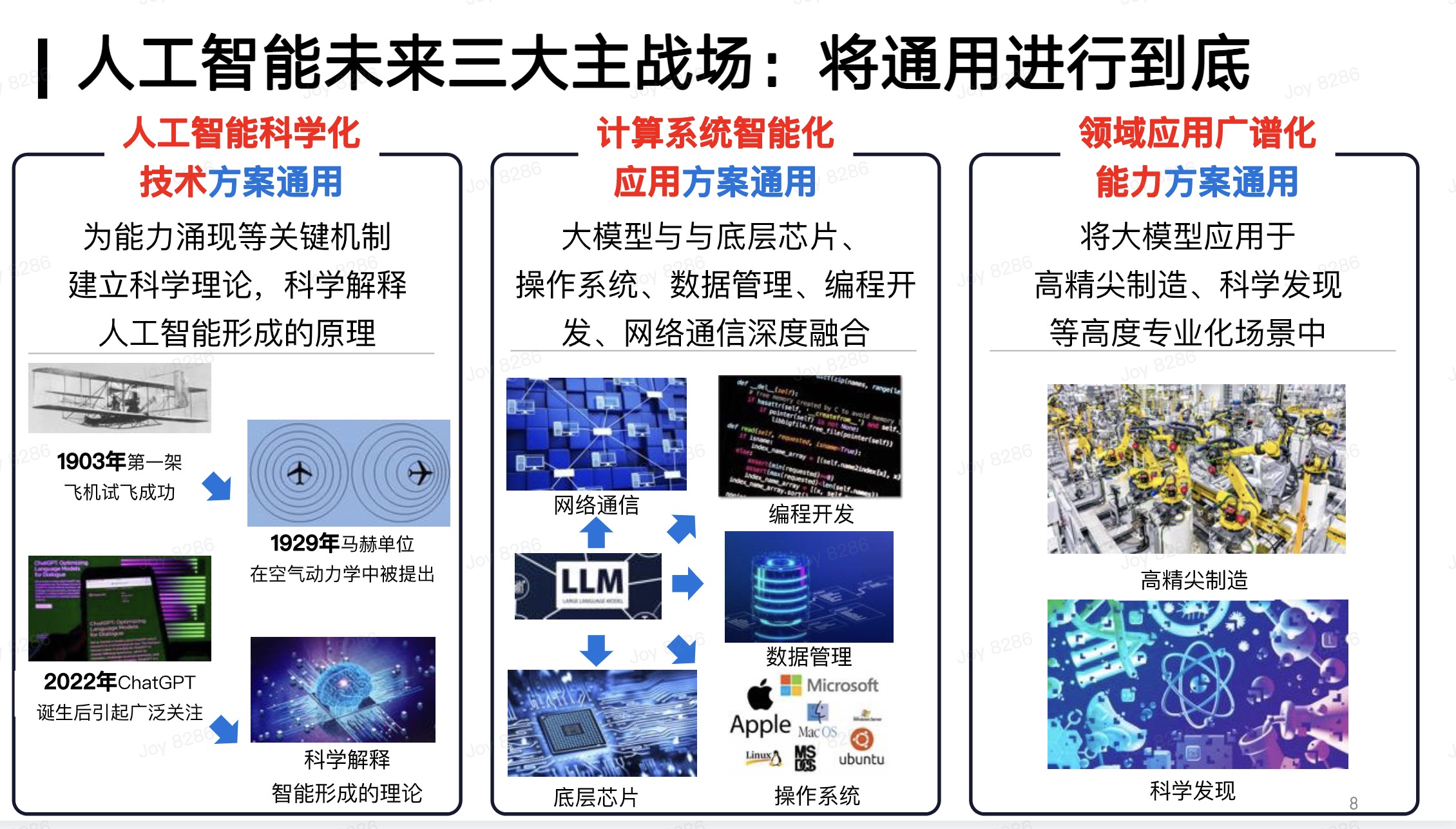

面向未来,我们认为人工智能有三大主战场,它们的目标都是让通用人工智能达到顶尖水平。首先,我们要探索人工智能的科学化技术方案,实现更科学、更高效的人工智能实现方式。其次,我们要实现计算系统的智能化,能够在计算层面以更低的成本、更通用地将大模型应用于各个领域。最后,我们也要在各个领域探索人工智能的广谱化应用。

以下是观众提问环节:

OpenAI犯了“傲慢之罪”

Q: DeepSeek的成功因素里,最有亮点的一个技术是什么?

刘知远:我觉得主要有两条启示:DeepSeek V3给我们的重要启示在于,它展示了如何用1/10甚至更少的成本完成达到GPT-4和GPT-4o水平的能力。DeepSeek V3在底层算力加速方面做了大量工作。但更重要的是,翟老师特别强调了DeepSeek V3实现了算法和底层软硬件的协同优化。这种一体化优化机制让大家看到,即使成本已经很低,但仍然可以通过优化进一步降低成本。虽然V3的成本仍然是几百万美元甚至几千万美元,但相比国际上公认的水平,已经低得多。这也是英伟达股价下降的一个重要原因。

DeepSeek R1的启示在于,OpenAI犯了“傲慢之罪”——它不开源,不公开技术细节,且定价过高。而DeepSeek的R1则开源且免费,让全球用户都能使用,并且公开了所有技术细节。这使得DeepSeek在历史上占据了原本应该属于OpenAI的位置,就像当年的ChatGPT一样。DeepSeek通过极致优化有限资源,成功追赶上了国际最先进的模型,我觉得干的非常漂亮,并且通过开源让全球都认识到中国团队的创新能力。

Q:为什么DeepSeek的 R1模型在这个时间点出现?之前有没有基于基础模型直接做强化学习的尝试?之前也有模型在思维链上做过类似工作,为什么DeepSeek的R1模型会如此出圈?

刘知远:我觉得这件事情还是具有一定的必然性。大概在2024年的时候,很多投资人,甚至一些不从事人工智能领域的人,会来问我:中国的AI和美国的AI相比,到底是差距变大了还是变小了?我当时明确表示,我们认为中国正在非常快速地追赶,与美国最先进的技术之间的差距正在逐渐缩小。尽管我们面临一些限制,但这种追赶是显而易见的。

一个重要的现象可以验证这一点:2023年初ChatGPT和后面GPT-4发布后,国内团队复现这两个版本的模型大概都花了一年时间。2023年底,国内团队复现了ChatGPT水平的模型能力;2024年四五月份,一线团队复现了GPT-4水平的能力。但随后你会发现,像Sora、GPT-4o这样的模型,基本上都是国内团队在大约半年内完成复现的。这意味着,像o1这样的模型能力,国内团队在半年左右复现是可预期的。

DeepSeek本身非常出色,其价值不仅在于能够复现,还在于它以极低的成本做到了这一点。这是它的独到之处,也是它脱颖而出的原因。但无论如何,国内一线团队能够在半年左右复现o1水平的模型能力,我认为这是可以预期的。DeepSeek能够更快、更低成本、更高效地完成这项工作,这是它的巨大贡献。从这个角度看,我认为有一定的必然性。

当然,DeepSeek能够达到这样的出圈效果,也离不开它自身团队的长期积累,这正如刚才邱锡鹏老师提到的那样。

Q:(评论区问题)刚刚知远老师 PPT 里提到的能力密度是如何定义的?它的内在原因是什么?

刘知远:这个“能力密度”的概念是我们最近半年提出的。关于如何有效地、准确地衡量能力密度,大家可以参考我们发表在arxiv 上的论文,论文题目是《Densing law of LLMs》。

所谓的能力密度,可以理解为模型在各种评测集上展现出来的能力,除以其参数规模,或者说是激活的参数规模。我们观察过去一年半发布的代表性模型,发现其能力密度大约每100天增加一倍。这意味着每过100天,我们可以用一半的参数实现相同的能力。这一现象背后有多个因素影响:

·1数据质量:更高的数据质量取决于数据治理。高质量的数据能够提升模型的训练效果。

·2模型架构:采用更稀疏激活的模型架构,可以用更少的激活参数承载更多的能力。

·3学习方法:包括OpenAI在内的所有一线团队都在开展所谓的“scaling prediction”。在真正训练模型之前,我们会进行大量的风洞实验,积累各种预测数据,以确定模型需要什么样的数据配比和超参配置,从而达到最佳效果。

综合这些因素,模型可以用更少的参数承载更多的能力。我们将这一现象类比为芯片行业的摩尔定律。摩尔定律告诉我们,每18个月,芯片上的电路密度会增加一倍。这一过程是通过不断的技术发展实现的。

进一步结合刚才翟老师和国浩老师提到的底层算力优化,我们可以将这种优化映射到模型训练阶段,从而极大地降低成本。当然,我们并不是说DeepSeek的算力可以用1/10的成本实现与国外模型相同的能力,但这与Densing law(能力密度定律)有一定的重叠。

Densing Law更多地强调模型密度的不断提高,这不仅体现在训练阶段成本的降低,也体现在推理阶段。模型可以用更低的推理成本和更快的推理速度完成相同的能力。我们认为,未来AI的发展一定会沿着这条路线前进。过去几年的发展也在不断验证这一点。一个直观的体验是,像OpenAI这样的公司,其API模型的价格(例如 ChatGPT 水平的模型和GPT-4水平的模型)在过去几年中快速下降。这不仅仅是因为价格战,而是因为它们可以用更少的资源实现相同的能力,从而以更低的成本提供服务。

我们认为,高效性是未来AI发展的一个重要方向,也是我们迎来智能革命的一个重要前提。

Q: MoE架构会是通向AGI道路上的最优解吗?

刘知远:我的个人感觉是,其实没有人永远是对的。

在2023年初,OpenAI发布ChatGPT时,它做对了;它发布GPT-4时,也做对了。但当它发布o1时,它做错了——它没有开源,定价策略也出现了失误。这反而成就了DeepSeek。我也不认为DeepSeek选择了MoE架构,MoE就永远是正确的。没有任何证据证明MoE是最优的模型架构。

从学术角度和AI未来发展的角度来看,我认为这是一个开放性的问题。未来如何实现高效性?我认为一定是模块化和稀疏激活的,但具体如何稀疏激活、如何模块化?我觉得这件事情本身应该是百花齐放的。我们应该保持开放性,鼓励学生和从业者像DeepSeek一样努力去探索创新。

所以,我本身不太认为MoE有任何绝对的壁垒,或者它一定是最优的方法。

DeepSeek所做的工作可能也是“摸着OpenAI过河”

Q:DeepSeek技术的爆发,对于中国大模型未来发展道路有哪些启示?

刘知远:首先,我觉得特别值得敬佩的是DeepSeek团队的技术理想主义。因为无论是看他们的访谈还是其他资料,你会发现,那些访谈其实是在DeepSeek大火之前很久接受的,内容非常真实,能够反映他们内在的底层逻辑。从这一点上,我们可以感受到DeepSeek是一个非常具有技术理想主义的团队,以实现 AGI 作为梦想来组建这个团队。我觉得这一点是非常值得敬佩的。

我觉得同时也会看到,DeepSeek的梁文峰之前做量化投资,本身投入自己的资金来开展项目,没有资金上的困扰。那么相对应地,我觉得中国应该为这样的技术理想主义团队提供支持,哪怕他们没有足够的资金,也能让他们没有后顾之忧地去进行探索。我觉得中国已经到了这样的阶段,需要有更多像DeepSeek这样的团队,但又不像DeepSeek这样有资金。能否让他们踏踏实实地去做一些原始创新,做一些出色的工作,这是我觉得非常值得我们思考的第一点。

第二点,我觉得是他们的执行力。DeepSeek今年这两个月一炮而红,大家会觉得很厉害,但实际上,这是经过了多年持续积累的结果。我们看到的是他们不断积累的进步,量变最终产生了质变。我可以告诉大家,几年前,幻方就拿着免费算力去吸引我们的学生,与他们建立联系。当然,也有学生毕业后加入了DeepSeek。所以,这是他们多年努力的结果。我认为这也是技术理想主义推动下的长期主义成果。我觉得国内应该有更多的团队,能够坐得住冷板凳,更加聚焦,在一些重要问题上持续发力,做出有意义的工作。

DeepSeek发展到今天,我认为他们所做的工作可能也是在“摸着OpenAI过河”,以OpenAI为榜样,去探索AGI的实现路径,并努力去做他们认为正确的事情。这个过程非常困难,尤其是随着OpenAI变得越来越封闭,o1复现的难度比当年的ChatGPT更大。但我们会看到,只要有理想和执行力,他们就能做到。所以在我看来,国内应该有更多的团队去学习。具体的技术当然是我们应该学习的一部分,但我觉得应该避免认为因为DeepSeek成功了,所以他们所做的一切都是对的。我觉得不一定他们所用的所有技术都是最先进的。我觉得没有必要因为DeepSeek这次成功用了这样那样的技术,就认为它们全都是对的。我觉得这反而会限制我们的创新。我觉得我们应该学习的是他们的理想,学习的是他们的坚持,学习的是他们的方法论。这是我想分享的第二点。

孙正义再次加注OpenAI。

当地时间2月7日,据外媒援引知情人士的消息,日本软银集团(SBG)即将敲定400亿美元对OpenAI的首轮投资,投前估值为2600亿美元。

据报道,软银的首笔资金最快将于春季到位,全部资金将在未来12-24个月内分期支付。该笔融资规模将打破OpenAI上一轮创下的硅谷单轮融资纪录。本轮融资后,不仅OpenAI的投后估值将相较上一轮融资后翻倍,达到3000亿美元,软银也将超越微软,成为OpenAI的最大投资方。

当地时间2月3日,软银CEO孙正义与OpenAI CEO山姆·奥特曼会谈。

就在几天之前,软银刚刚与OpenAI达成协议,将在日本成立合资企业“SB OpenAI Japan”,共同打造名为“Cristal(水晶)”的人工智能产品,为企业提供服务。孙正义表示,软银每年将在OpenAI产品部署上投入30亿美元。

前述消息人士称,此次融资的部分资金预计将用于兑现OpenAI对“星际之门(Stargate)”项目的承诺。

“星际之门”启动,奥特曼“全球路演”

美国总统特朗普在1月21日宣布了“星际之门”项目,软银、OpenAI和美国甲骨文公司(Oracle)三家企业将投资5000亿美元,用于建设这一史上最大的AI基础设施投资项目。软银CEO孙正义将担任“星际之门”项目主席,软银承担项目的财务责任,OpenAI负责公司运营,并自主建设和管理数据中心。

据介绍,项目初始投资为1000亿美元,并计划在未来4年内扩展至5000亿美元,预计将为美国创造10万个就业岗位。

当地时间1月23日,OpenAI CEO山姆·奥特曼(Sam Altman)晒出“星际之门”在美国得克萨斯州首期工厂的视频,第一期已确定在美国得克萨斯州阿比林数据中心基地展开,计划打造10个数据中心。

当地时间2月6日,OpenAI表示正考虑在美国16个州建立数据中心园区,预计每个数据中心园区将创造数千个就业机会,包括建设和运营岗位。但根据最近的报道,“星际之门”在阿比林的首期数据中心只能创造57个就业机会。

除了日本,奥特曼近期还前往了韩国和印度。

2月4日,奥特曼现身韩国,与SK集团董事长会面,又和孙正义一起与三星电子董事长会谈。当天,OpenAI还宣布与韩国最大的社交应用运营商Kakao达成战略合作关系,双方计划共同开发面向韩国市场的AI产品。

奥特曼透露,OpenAI正在积极考虑投资并加入韩国的人工智能计算中心项目,并暗示韩国企业可能会参与“星际之门”项目。

2月5日,印度信息技术部长阿什维尼·维什瑙(Ashwini Vaishnaw)与奥特曼会面,讨论涉及GPU、模型和应用程序的AI战略。

当地时间2月7日,奥特曼又已现身德国,在柏林工业大学参与了AI专题活动。

当地时间2月7日,山姆·奥特曼现身柏林工业大学,

据悉,奥特曼此次“全球路演”还会前往法国、迪拜等地。

DeepSeek震惊硅谷,OpenAI还有“后手”?

OpenAI着急寻求合作和投资,恰逢来自中国的DeepSeek在硅谷引发轰动。

1月20日,中国AI初创公司深度求索推出开源大模型DeepSeek-R1,性能比肩OpenAI o1模型正式版,而训练成本或仅需约600万美元。

如此“物美价廉”,Meta、微软、OpenAI、Anthropic等公司纷纷关注跟进。投资界大佬们也都现身表态,方舟投资(ARK)CEO“木头姐”凯西·伍德表示DeepSeek证明了AI领域成功并不需要那么多钱,加速了成本崩溃;桥水基金创始人瑞·达利欧表示,中国在芯片上或许落后,却在应用上实现了领先,AI竞争比企业盈利更重要,但投资者对AI的狂热助长了美股的“泡沫”,其程度类似于千禧年的互联网泡沫……

奥特曼曾评价称,DeepSeek让OpenAI的领先优势将不会像前几年那么大了,并称个人认为在开源权重模型和研究成果的问题上,OpenAI已经站在了历史的错误一边,需要制定不同的开源策略。

不过,在1月27日的一次采访中,奥特曼表示,DeepSeek的“这种性能并不新颖,我们早已具备这一水平的模型,今后将持续开发更先进的模型”。

2月7日,OpenAI也公开了o3-mini大模型的思维链。不过,与DeepSeek不同,o3-mini的思维链文本并非大模型原始思维链,而是进行过“总结”。对此,奥特曼的解释是,OpenAI正努力整理原始的CoT(思维链)提升可读性,并在必要时提供翻译,尽量保持原始内容的忠实度。

OpenAI大模型o3-mini的思维链文本。

巨额融资和更多的合作方,不仅可以让OpenAI推进算力扩张、模型及智能体(agent)研发,也可以助力其在硬件方面的布局。

OpenAI自2024年底开始已在重组机器人部门,Meta增强现实(AR)眼镜团队前负责人凯特琳·卡利诺夫斯基(Caitlin Kalinowski)已经官宣加入并负责机器人和消费硬件业务。

今年1月末,OpenAI向美国专利商标局提交新的商标申请,涉及人形机器人、XR、智能手表、可穿戴设备等硬件设备。

奥特曼还曾在采访中透露,将与苹果前设计负责人乔尼·艾维(Jony Ive)创立的企业合作,推进开发AI终端,不过公开原型机尚需数年时间。

对于AI开发中不可或缺的芯片,奥特曼表示“公司正在自主研发”,但未透露具体细节。

值得一提的是,当地时间2月4日,OpenAI长期投资的美国机器人初创企业Figure的创始人布雷特·阿德科克(Brett Adcock)宣布将终止与OpenAI的合作。他表示Figure在完全自主研发的端到端机器人AI上已取得重大突破,并将在未来30天内展示一些从未在人形机器人上看到过的东西。

这像极了OpenAI曾与微软达成的协定——一旦达到AGI(通用人工智能)水平,就可以终止与微软的独家合作关系。

OpenAI究竟能否“遍地开花”?外界可以拭目以待。

今年春节,国产AI公司深度求索开发的大模型DeepSeek成为爆款,作为一款开源、免费的大模型,尽管还未实现盈利,但第一批用它“搞钱”的人已经出现了。

2月6日晚上,曾经广受关注的“AI卖课第一人”李一舟在自己直播间兜售创业课程时谈到DeepSeek,称背后有很多创业机会,“这个我就不方便多说了,非常值得大家去学习和使用。”

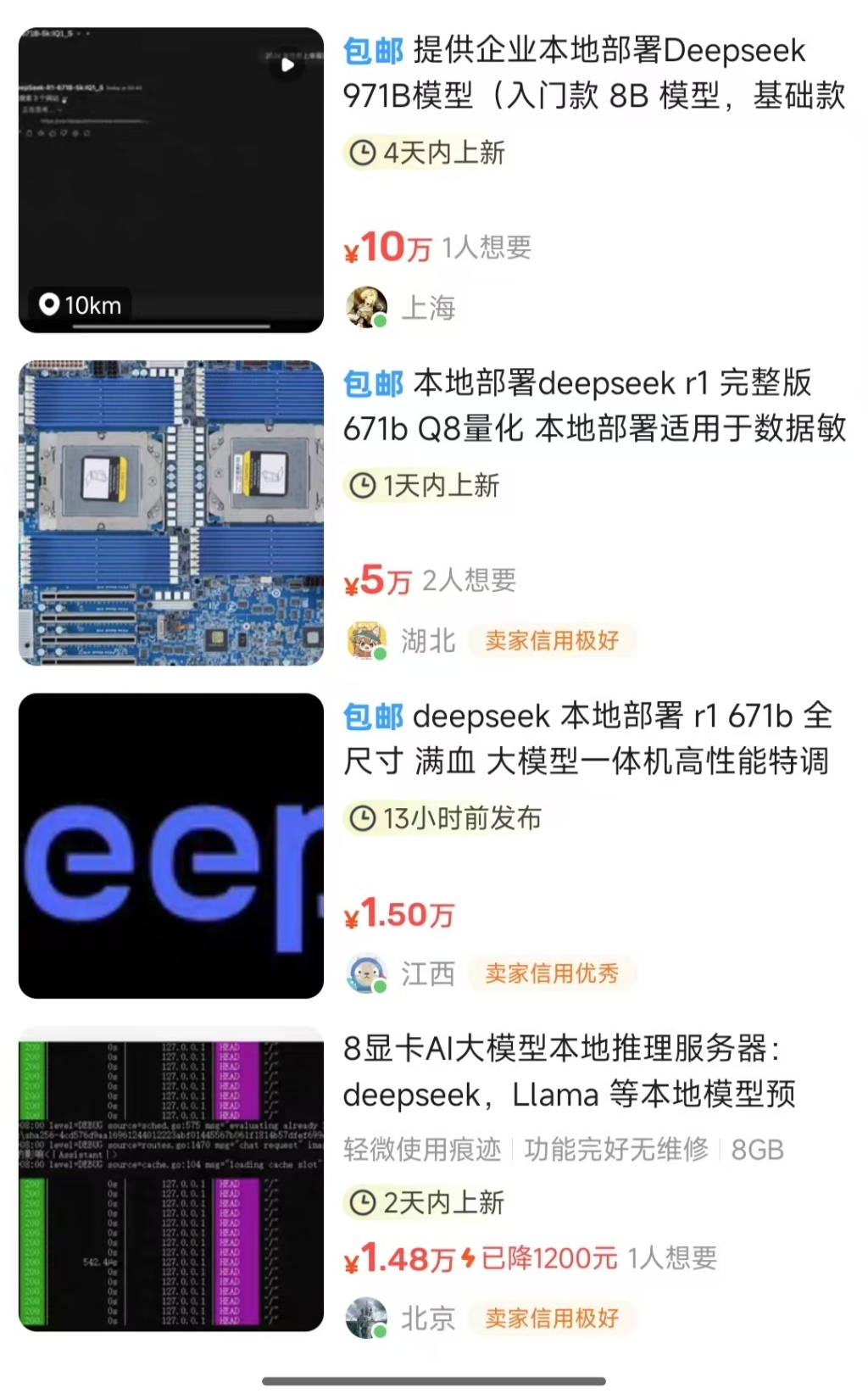

“如何用DeepSeek赚到100万”“DeepSeek带你躺着赚钱”......在社交媒体上,频频能看到教你如何用DeepSeek实现一夜暴富,在淘宝、闲鱼等平台上,不少商家打着“本地部署”的概念兜售DeepSeek接入教程,标价最高达到10万元,最低仅有0.01元。

澎湃新闻记者查询发现,某热门DeepSeek社区会员费为61元,总会员数超过3600人,在DeepSeek爆红的近一个月里,仅会员费收入就超过18万元。

对于各类利用DeepSeek牟利的投机者,6日晚间,DeepSeek官方发布声明:目前除DeepSeek官方用户交流微信群外,从未在国内其他平台设立任何群组,一切声称与DeepSeek官方群组有关的收费行为均系假冒。

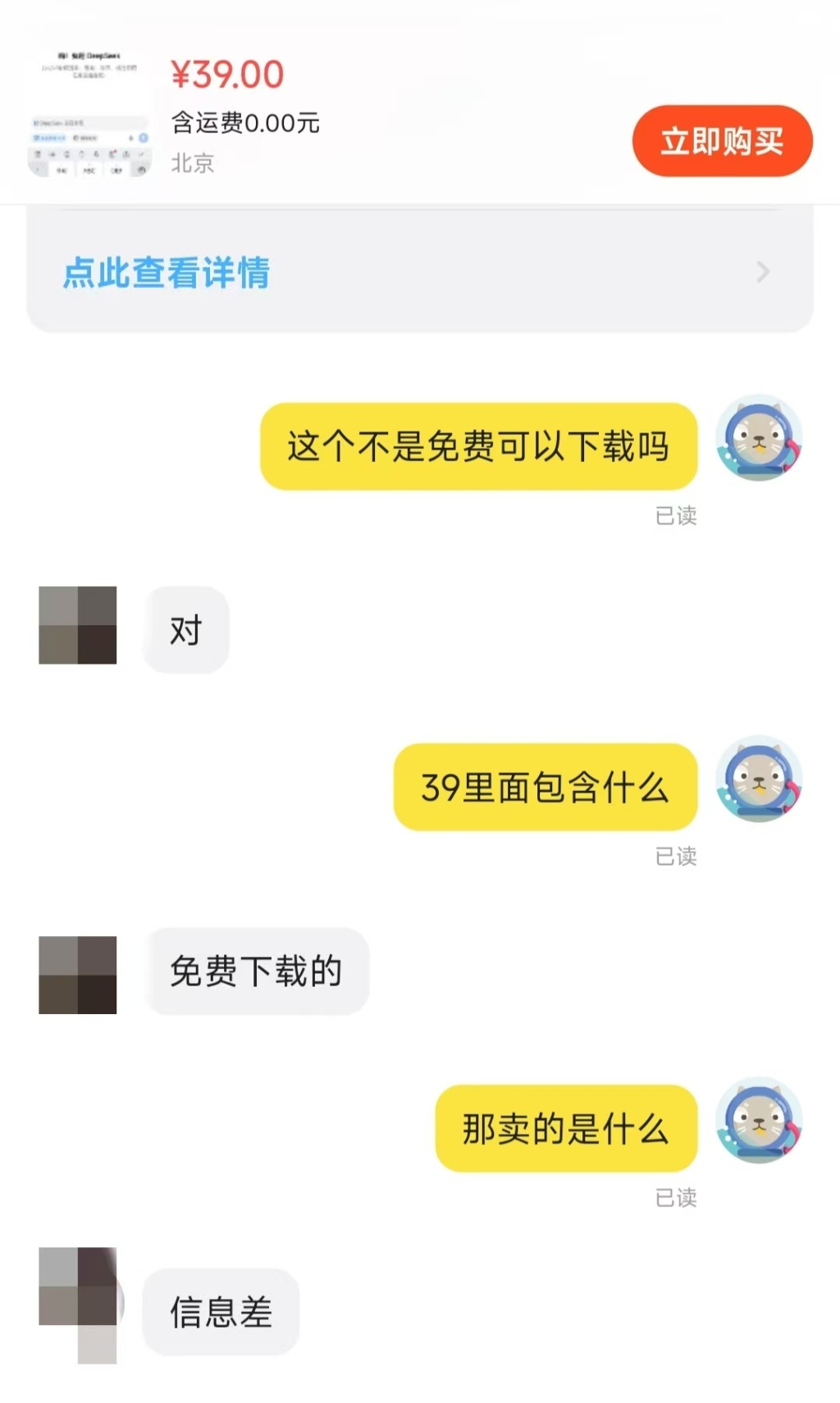

利用“信息差”牟利

DeepSeek最大的特点就是是开源,而在多家电商平台上,有商家公然售卖可以免费下载的DeepSeek软件,并且不加掩饰地告诉记者:“卖的就是信息差。”

无论是元宇宙、Sora还是DeepSeek,每当新一波革命性技术迎来讨论,似乎“卖铲子”的人总是最先挣钱。据新榜数据显示,近7天内,在抖音、快手、B站、小红书、微博、微信等平台上,和DeepSeek相关的内容作品数至少在105万条,日均作品数超15万。

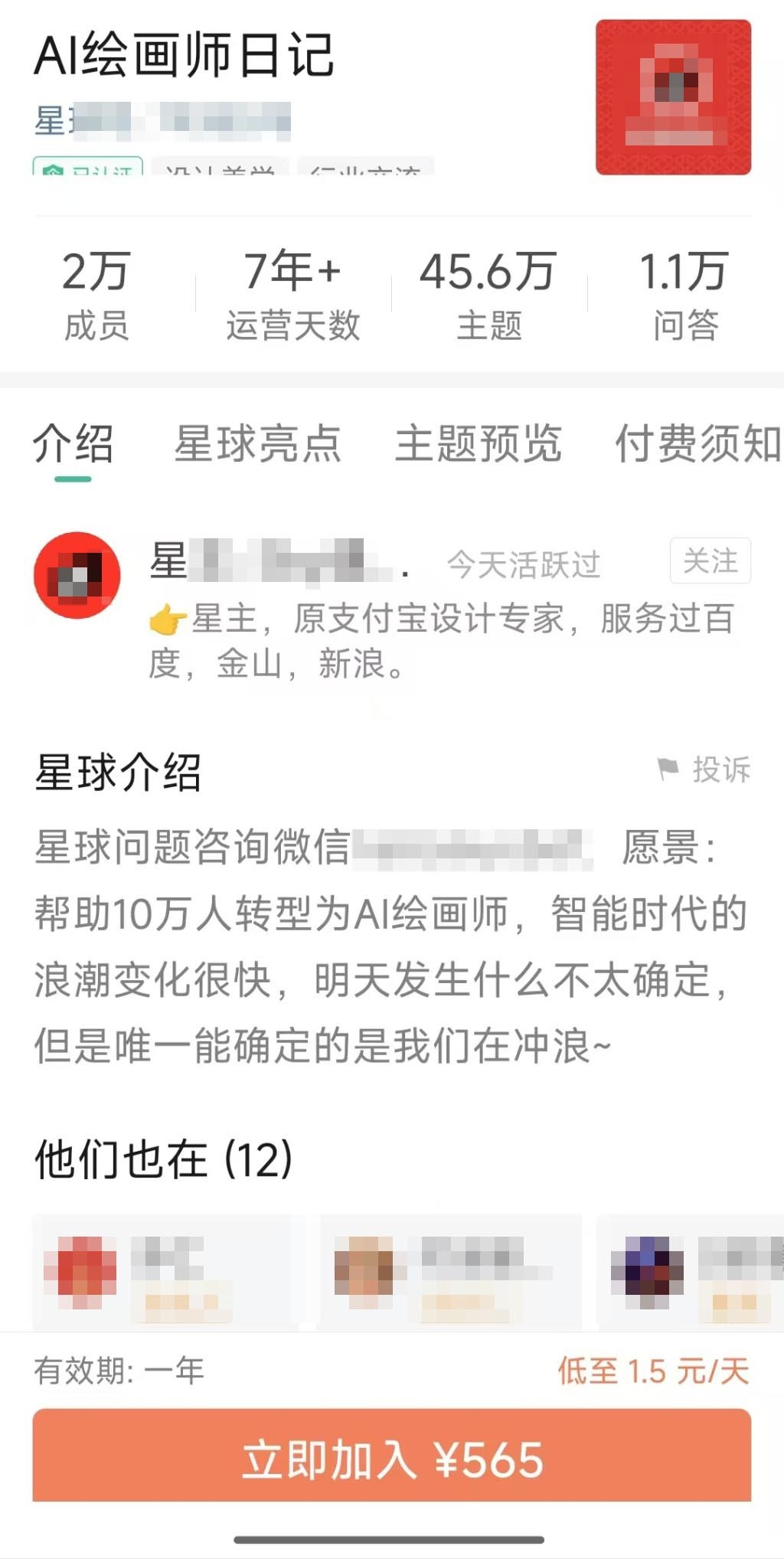

在付费知识社群“知识星球”上,记者搜索到超过百个DeepSeek相关社群,基本内容都是分享DeepSeek相关课程,会员收费从50元到200元不等。

某热门DeepSeek社群收费

不少荐股博主还开发出DeepSeek的炒股功能,在抖音直播间里,记者看到,有博主宣传只要用同花顺等炒股软件接入DeepSeek,就能控制电脑全自动分析股票,在直播间下方还附上了教程和软件的购买链接。记者联系到了其中一位用DeepSeek分析股票的荐股博主,对方称自己已经被封号。

博主在抖音直播间宣传用DeepSeek炒股

除了传统的售卖AI培训课、AI社区付费等套路,售卖DeepSeek本地部署教程成为新的掘金方式,不少商家挂出5万元、10万元高价。

所谓的本地部署,意思是把DeepSeek模型下载到电脑上,然后用电脑的显卡进行推理。闲鱼上一位商家告诉记者,标价5万元是包含主机的价格:“DeepSeek对硬件要求很高,一般普通电脑根本跑不了完整版本。”

“本地部署,精细化AI”“API调用训练”“可以自行投喂数据”在平台上,关于本地部署DeepSeek的教程软件泛滥,从几分钱到几元钱、几十元价格不等,仅凭介绍很难分清有什么区别。

有商家告诉记者,这是因为不同价格售卖的版本不同,价格低廉的大多为蒸馏版DeepSeek,可以进行基础问答但没有推理能力,而满血版DeepSeek需要强大的算力支持,即便付费购买了软件,没有配套的硬件设施也无法运行。

这些商家行为显然就是利用DeepSeek可以本地部署的幌子,真正目的是销售硬件,但性价比对于一般用户而言却无法判断辨别。

AI概念火热,新兴职业涌现

售卖这些五花八门、标价混乱的本地部署课程和软件,是否涉嫌利用DeepSeek非法牟利?

记者查阅DeepSeek官方文件显示,由于是开源大模型,允许本地部署服务,但涉及到商业销售和牟利,就可能涉嫌触犯法律。协议显示,官方提供的模型和工具(如通过Ollama部署)遵循MIT开源协议,协议允许商业使用、修改和分发,但需保留版权声明并明确免责条款。

在遵守MIT开源协议的前提下,第三方提供本地部署技术支持或托管服务是允许的。但若涉及模型权重的商业化销售、未经授权的二次分发,或未履行开源协议义务,则可能构成侵权。

值得一提的是,除了利用DeepSeek赚钱,已经有不少掘金者涌入了AI赛道,例如AI画师、AI视频剪辑、AI文案创作等新兴职业如同雨后春笋一般出现。以某AI绘画社区为例,会员费用为565元,目前共有2万会员,以此初步推算,一年会员费收入就接近千万元。

有AI视频创作者表示,自己利用AI软件春节帮企业制作了以喜庆蛇年为主题的一些短视频,再配上喜庆的歌曲和文字,发布不久后就获得了几万的点击量,挣到了六位数的推广费。也有人通过做AI视频引流,进行橱窗带货,获得了超过8000元的佣金收入。

也有原影视团队转型做AI,以“自然风景+AI”“热门IP+城市地标+AI”的模式,利用AI生成脚本、图片、视频、配音、后期等流程产出成片,在半年内盈利约30万元。

还有人用AI生成文案、用AI作图等,有绘图作者提到,自己通过Midjourney和Stable Diffusion在春节生成了不少AI绘画作品,比如带有福字、舞狮、蛇年等图案的各类壁纸,非常受欢迎。有创业者靠定制AI头像和壁纸的业务,在春节期间收入超10万,“只要抓住机会,这一两年里就能积累巨额财富。”

“目前AI培训领域存在鱼龙混杂、良莠不齐的现象,部分机构缺乏资质,存在夸大培训效果、利用信息差收取暴利费用等情形。”华东政法大学竞争法研究中心执行主任翟巍向澎湃新闻记者表示,依据《反不正当竞争法》《消费者权益保护法》等法律法规,应当对DeepSeek培训领域予以规范和引导,以保障AI培训行业的健康有序发展。

对于突然涌现的大量AI新兴职业,翟巍认为,由于对人工智能投喂的语料(训练数据)可能本身存在侵犯版权、商业秘密或个人隐私情形,因此人工智能生成的作品可能出现衍生的侵犯版权、商业秘密或个人隐私后果。

此外,关于人工智能生成作品的法律属性和权益主体问题,现在缺乏明确的法律规定,这一方面导致利用人工智能生成作品的个人难以依据现有法律主张自身对这些作品享有财产、人格权益,另一方面也导致在人工智能作品侵犯他人权益的情形下,难以确定侵权责任的承担主体。

“AI(人工智能)的尽头是医疗。”“用更好的AI,守护人们的健康。”2025全球开发者先锋大会(GDC)第二天,2月22日下午,在“AI焕新,塑医疗未来”论坛上,这两句话被人们多次提起。AI正深刻地影响医疗行业:从医学影像的智能诊断到手术机器人辅助操作,到临床决策支持和医院管理……谁能领跑“AI+医疗”这一新赛道?

2025全球开发者先锋大会(GDC)第二天,在上海市徐汇区西岸艺术中心A馆召开的“AI焕新,塑医疗未来”论坛,会场边上围了一圈挤不进现场的人。

从上海交通大学医学院附属瑞金医院发布病理大模型,到上海市第六人民医院推出全球首台贴片式超声设备及AI识别技术,再到上海市建成集“算法-算力-数据”三位一体的医疗大数据训练设施,通过不断降低医疗AI技术门槛、加速产业集群与创新生态构建,上海正逐渐建设成为包括医疗人工智能在内的AI应用“高地”。这一战略优势的形成,源于上海独特的医教研资源禀赋——复旦大学、上海交通大学等顶尖学府不仅拥有实力雄厚的医学院及附属医院,更在医工交叉学科领域形成突破性创新链,持续产出具有国际影响力的前沿成果。

上海临床创新转化研究院(以下简称“临转院”)总裁段琦向澎湃科技表示,作为医疗人工智能产业的创新枢纽与赋能平台,临转院将加快技术攻关并孵化出更多高质量的医疗人工智能应用与产品,全面提升医疗行业效率与质量,缓解医疗资源供给不足的问题,创造更大的经济价值。

“上海是中国做垂类大模型(垂直领域大模型)及应用场景做得最好的城市之一。”22日,上海市人工智能行业协会副秘书长沈涛在主持圆桌讨论时说,而“AI+医疗”是其中最重要的行业之一。

先行者基因:政策引擎,生态筑基

早在2017年10月26日,上海市人民政府办公厅就印发《关于本市推动新一代人工智能发展的实施意见》的通知,提出利用认知计算和深度学习技术,提升诊疗辅助、健康管理和养老照护等服务能力。加强自主智能医疗机器人和医疗设备等在辅助病症诊断、影像分析、手术诊疗、精准医疗中的推广应用,促进医疗服务精准化。

随后,上海又先后出台了《加快推进上海人工智能高质量发展的实施办法》(沪经信技〔2018〕569号)、《关于建设人工智能上海高地构建一流创新生态的行动方案(2019-2021年)》(沪经信智〔2019〕707号)等政策文件,推动人工智能创新布局。此外,上海还设立人工智能创新发展专项资金,对人工智能产业领域的创新项目予以支持。

其中,医疗行业是上海加快推动人工智能垂直领域的规模化应用的六个重点行业之一。

“模型群”

上海市肺科医院副院长陶蓉表示,“我们研发了那么多医疗AI大模型,未来希望推广到更多医院去。”她认为,应该基于高质量的医疗数据和正确的标注,研发一个个基于单病种的专业的大模型,然后推广、落地、应用,反哺临床。

她介绍,上海市肺科医院目前已实现DeepSeek70b与671b模型本地化部署。在大模型研发方面,该院首先着力于AI医学影像辅助系统。“我们每天有4000多名患者拍CT,医生阅片、诊断的工作量非常大,非常辛苦。现在已经能够把筛查出来的内容整合到模板当中,快速生成文字的描述,进入报告中,大大提高了工作效率。”换句话说,CT影像检查不再积压,检查报告当天就能生成。

作为专科医院,在单病种AI模型方面,上海市肺科医院联合人工智能企业商汤科技进行本地化搭建智慧病理数智一体化平台,目前正在对数字病理切片进行标注和模型训练。

上海市肺科医院副院长陶蓉

此外,上海市肺科医院还研发了肺部智能手术规划系统。“(以前)影像片导入之后需要花2-4个小时,现在只要2-5分钟的时间就能够做三维的重建、手术的规划模拟等。”陶蓉说。

上海交通大学医学院附属瑞金医院-上海市数字医学创新中心专职副主任朱立峰介绍,瑞金医院研发的医疗AI大模型目前形成了“大模型群”,来“支撑”医生、服务患者,并“支撑”该院的医学教育以及医院的管理。

四天前,2月18日,上海交通大学医学院附属瑞金医院刚刚发布了一个病理大模型——RuiPath(瑞智)。

他介绍,一方面,瑞智是一个泛癌种的基础大模型,覆盖中国全癌种人数90%的癌种,并且完成了视觉和语言的跨层表征;此外,它还是一个推理大模型,具备深度思考能力,可以开展互动式病理诊断对话。该模型使用瑞金医院积累的100万张的WSI数字病理切片影像数据,包括对应的报告文本,完成训练。

上海交通大学医学院附属瑞金医院-上海市数字医学创新中心专职副主任朱立峰

此外,瑞金医院还研发了胸部影像大模型和医学文档大模型。

在“体检总检报告生成”落地应用场景中,相关大模型可以智能分析各项体检报告,自动识别高风险异常,提供个性化健康建议,大幅提高书写效率和质量。从2023年12月至今,已生成超过10万份报告;而在“电子病历生成”的应用中,根据患者入院后各项诊疗数据,智能识别异常情况、归纳总结诊疗过程,生成住院期间的医疗情况、病程与治疗情况、出院后用药与建议等完整病历。

“截至2月19日,全国至少14家三甲医院部署了国产AI大模型DeepSeek,包括上海市第四人民医院、上海市第六人民医院、昆山市第一人民医院等。”在演讲中,段琦援引相关统计数据称。

2024年,来自昆山市第一人民医院的“昆山模式:老年健康管理与生物医学大数据创新应用”成功入选江苏省首批“数据要素X”典型案例名录,成为当地医疗与人工智能深度融合的标杆。昆山市第一人民医院-昆山生物医学大数据创新应用实验室负责人陆轲表示,该医院通过将实验室自研模型与DeepSeek推理版底座深度整合,嵌入医院HIS(医院信息管理系统)、PACS(影像归档和通信系统)等系统,让“智慧底座+自研模型+院内数据”多模态协同。

上海六院:AI+硬件,打造全球领先的超声“识别”

上海市第六人民医院副院长郑元义表示,如果能把AI与硬件结合,协同创新,就能做到“非常强的创新”。

上海市第六人民医院副院长郑元义

为了提高安全性,规避X射线辐射带来的风险,他们团队希望设计出一款适用于妇女儿童的设备——手骨骼超声AI成像,用超声检查替代X射线检查,其识别的过程需要AI的帮助。上海六院通过与汕头超声公司、上海交大AI团队合作研发了手扫描超声设备,能把每根手指的骨骼识别出来,初步建立了“国际首创的、不依赖X线”的儿童骨龄超声AI预测新方法,正在加大临床研究样本。

郑元义介绍,他们还与华中科技大学联合研发了“肌骨超声断层成像”设备,能够识别出骨骼、神经、血管、肌肉等结构,通过“超声检测+AI识别”,有很多的临床应用。上海六院将他们研发的设备命名为UT(超声断层成像),以区别于CT(X线断层成像),目前“国际上还没有进入临床应用的同类产品”。他们还研发了可穿戴的贴片式超声,获得了国内第一张贴片式超声注册证,用“超声检测+AI识别”的方法可用于评价人体肌肉收缩力相关指标,目前已服务于国家重大航天项目。此外,这种设备与AI结合还可用于24小时无创、实时血压监测,已进入临床研究阶段。郑元义表示,这些创新设备的成功研发,离不开团队获得国家重点研发项目、上海市科委重点临床研究项目以及上海交大STAR成果转化项目等基金项目的资助。

上海临转院:以赋能医疗大健康产业为使命,面向行业全方位赋能

2024年7月,上海市政府在《关于加强本市临床研究体系和能力建设支持生物医药产业发展的实施意见》中指出,要持续推进临床研究成果转化,支持建立市场化、专业化的医学科技成果转化服务平台,促进高质量科研成果转化,并探索建立作价投资的转移转化创新模式和路径。

按照市委市政府的部署要求,2024年9月20日,由上海申康医院发展中心牵头组建的临转院正式成立,下设“临床研究与疾病队列建设、转移转化与投资、数据挖掘与人工智能”三大业务板块,服务于上海建设全球生物医药产业高地的战略目标规划。其中,数据挖掘与人工智能作为核心业务板块之一,围绕医疗人工智能技术研发、真实世界数据挖掘分析、高质量多模态医疗语料建设等方向开展工作,探索数据要素赋能医疗大健康与人工智能产业发展,助力上海医疗卫生健康产业整体的数字化、智慧化转型升级。

上海临床创新转化研究院总裁段琦表示,临转院将推动人工智能的规范化应用与产业赋能,孵化出更多高质量的医疗人工智能产品和技术。

临转院总裁段琦介绍,临转院将广泛合作积极开展医疗健康数据的应用创新,加快人工智能在生物医药、医疗器械、健康保险等领域的赋能与应用,深化跨界协同支撑产业发展。

技术应有的“温度”:人本医疗

22日的论坛上,医疗科技企业卫宁健康总裁王涛表示,“我们认为AI医疗的想象空间不仅仅是‘用AI辅助医生’,而是会以技术变革,重塑现有的医疗服务模式,例如预防性医疗、个性化医疗、整合性医疗等,从而为人民群众生命健康带来真正的福祉。”“我们相信,AI技术将为医疗普惠带来巨大帮助,有望通过AI进一步缩小城乡医疗差距,更好地促进医疗公平。”

从“以人为中心”理念出发,卫宁健康近年来打造了多款赋能医护人员的AI创新应用,包括本次论坛上发布的迭代版医疗大语言模型WiNGPT和AI产品WiNEX Copilot。“我们的初心不是以AI替代医生,而是增强医疗的能力和效率,让技术成为医生的伙伴。”卫宁健康副总裁兼CTO赵大平表示。

上海太翼睿景计算机科技有限公司董事长雷新刚在圆桌讨论中表示,“国家卫健委2024年发布了84个卫生健康行业人工智能应用场景,其实医疗健康的应用场景远远不止84个,我们的定位是,根据自己的能力和资源,深耕精神心理科、重症医学科、康复科,利用大模型的技术,做精做深,来赋能医院,提升效率和质量,改善患者的感受。”

“我们希望通过数据算法以及算力的加持,来回归我们整个医疗的本心。最终把冰冷的技术,化作温暖的服务,温暖患者,温暖医务人员。”陶蓉说。

“截至2月19日,全国至少14家三甲医院部署了国产AI大模型DeepSeek,包括上海市第四人民医院、上海市第六人民医院、昆山市第一人民医院等。”在演讲中,段琦援引相关统计数据称。

上海市肺科医院目前使用的大语言模型嵌入了患者风险预警,它结合检验影像等一系列的内容,对治疗过程中可能的风险进行预判、预警。而嵌入的知识库在医生在书写病历过程中,就可以进行内涵质控,如果发现存在缺陷,可以及时通知医生。

陶蓉介绍,该医院目前部署的智能输液监控区别于之前的称重输液监控,现在用的是固定摄像头进行图像采集,然后自动进行分析和计算,估算液量,进行决策和自动呼叫,准确率达到98%,从而减少了输液不良事件的发生,也降低了医疗成本。此外,该医院还部署了可以人机对话的AI机器人进行智能随访,显著提高了随访成功率。

开源是大模型发展的重要因素,DeepSeek的出圈进一步催化了模型开源。2月21日-23日,在上海举行的2025GDC全球开发者先锋大会上,多位嘉宾探讨模型开源趋势。开源到底对产业发展有哪些影响?开源是否会取代闭源?为什么说开源和闭源都或不可缺?看看嘉宾们都怎么说。

香港科技大学校董会主席、美国国家工程院外籍院士沈向洋:希望开源社区能贡献更多数据

沈向洋表示,互联网的出现令开源蓬勃发展,DeepSeek的火爆出圈是开源社区的胜利,将了不起的模型开源,就能让更多人在模型上做更多了不起的事。尽管当前闭源的份额仍然超过开源的份额,但接下来一两年将剧烈变化,平衡开源与闭源,引领未来。“大模型时代,开源并没有像以往那么多、那么快,我想,通过上海的努力,我相信开源这件事情会越做越好。中国的团队、上海的团队一定会引领开源潮流。”他也呼吁开源数据,“我希望开源社区能贡献更多数据,在新的范式里,大家一起有更大的进步。”

密度科技有限公司CTO刘益东:开源已成为不可逆转的潮流

刘益东表示,开源为行业生态注入活力,开源一定是潮流。DeepSeek证明开源是大势所趋,开源也一定能够带来产业欣欣向荣、爆发式增长的路径。国内大公司逐步加入开源行列,正是因为开源能够促进生态繁荣,进而反哺技术研发和应用场景拓展。开源还能带动产业上下游协同发展,形成良性循环。过去一些企业会开源部分模型参数,同时保留更优参数用于闭源服务。然而,当前趋势表明,无论是国内还是国外,开源已成为不可逆转的潮流,即便是曾经持保守态度的企业也不得不顺应这一趋势。

Linux基金会金融科技开源基金会技术监督委员会委员、前任全球董事安德鲁·艾肯:开源透明对AI至关重要

Linux基金会金融科技开源基金会技术监督委员会委员、前任全球董事安德鲁·艾肯表示,开源透明对AI发展至关重要。开源将提升社区凝聚力,在降低成本的同时提高AI技术使用率。开源也将提升产业信任度。未来AI企业需要在盈利性和商业价值上找到新的平衡点。

首个AI安全研究员朱小虎:开源项目商业化基本规则

首个AI安全研究员朱小虎介绍,开源社区或开源项目的商业化通常遵循一些基本规则:基于开源项目,企业可以开发针对特定领域的商业化产品或进行优化,并通过销售或寻找客户实现盈利。然而,开源对企业仍有一定门槛,其研发团队必须具备一定实力。目前一些企业虽在推动开源,但研发能力不足,可能仍需购买研发阶段的产品以满足需求。

星环科技副总裁杨一帆:开源叠加企业自身业务“护城河”是热点

星环科技(688031.SH)副总裁杨一帆表示,DeepSeek为AI开源“打样”,对人工智能行业从业者而言,开源叠加企业自身业务“护城河”,结合对场景、数据的理解,是未来的发展热点。

Hugging Face工程师王铁震:开源模型是工具,闭源模型是产品

王铁震表示,开源模型给了其他开发者微调的权利,开发者拿到一个基础模型后,可以通过模型后训练的方式让模型进化,模型“吃”到专有数据,可以变得更聪明,甚至可以蒸馏成更小的模型,降低服务部署成本。

但王铁震也表示,开源模型是工具,闭源模型是产品。“工具有些地方有棱角,拿的时候可能伤手。”王铁震表示,相对于只需调用API的闭源模型,要在公司内部把开源模型利用起来,需要配备一个技术团队,“开源模型首先要有自己的机房,要在网上申请一个服务器,要部署,需要知道怎么动态调整用户需求等等。”因此要客观看待开闭源的优劣势。

“最早,大语言模型火起来完全是由闭源模型带起来的,在ChatGPT起来之前已经有很多开源模型,但正是因为开源模型有本质的不足,不方便用,很多人看不到这个领域的进展,直到ChatGPT把英文模型拿出来,大家用了都说好,才引起了社会广泛关注。”王铁震认为,DeepSeek爆火并不仅仅是因为DeepSeek是开源模型,DeepSeek推出R1模型不久后就在全球上线APP,“如果没有DeepSeek方便易用的APP,只靠传统模型,是没有办法获取现在的影响力的。因为普通人用不起来,我们需要有更多更好的方式让普通人也能把模型用起来。”

野外作业现场

记者近日从中国第41次南极考察队获悉,为深入开展东南极拉斯曼丘陵地区冰下地质环境研究,在中国第40次南极考察期间,吉林大学和中国地质大学(北京)联合俄罗斯海洋与地质矿产资源科学研究所组成联合科研小组,在中山站以南约25千米处,利用我国自主研发的新型铠装电缆悬吊式电动机械深冰及冰下基岩取芯钻机(IBED)成功钻穿了545米厚的冰层及冰岩夹层,获取了连续冰芯样品和0.48米的基岩样品。

中俄科研小组

在第41次南极考察期间,中俄科研小组利用自主研发的测井仪器开展了钻孔摄像,获取了完整的冰川内部温度剖面,测量了钻孔倾角和方位角,同时对钻孔缩径过程开展了持续观测,获取了重要的原位冰川运动参数。此外,中俄科研小组还从钻孔内回收钻井液约7立方米,践行了环境保护的理念。

测井仪

这是我国首次在南极冰盖基于已有钻孔开展测井作业,获取了钻孔温度、倾角、方位角以及钻孔直径变化等关键参数,从而为探明东南极伊丽莎白公主地末端冰盖底部地热通量及其动力学演化机制奠定了基础,为揭示未来气候变化背景下的南极冰盖演化规律提供了重要依据。

拉斯曼丘陵地区位于伊丽莎白公主地冰盖末端,是东南极冰盖重要的溢流区之一。冰下地质环境是影响冰盖运动的重要因素,探明拉斯曼丘陵地区冰下地质环境对揭示东南极伊丽莎白公主地末端冰盖的动力学演化机制和物质平衡特征具有重要意义。

新模型周周见,Anthropic前脚推出混合推理模型Claude 3.7 Sonnet,OpenAI立马打出GPT-4.5这张牌。当地时间2月27日,OpenAI推出GPT-4.5,其追随用户意图的能力更强,“情商”更高。OpenAI CEO山姆·奥特曼将其形容为“是一种不同的智慧”,有一种他从未感受过的魔力。

虽然GPT-4.5作为一款非推理模型展示了在预训练进一步扩展后的能力提升,包括更高的准确性和更少的幻觉。但值得关注的是,在DeepSeek掀起开源潮和降价潮后,显然海外市场并没有被“卷”到,这次的GPT-4.5定价堪称“非常贵”,导致很多人感叹“一般人可用不起”。但从另一方面来看,中国科技企业开拓海外市场的必要性好像更大了。

“情商”更高,更懂暗示

据了解,GPT-4.5在扩展预训练和后训练规模上迈出一步,OpenAI通过扩展无监督学习和推理两个互补范式来提升人工智能的能力。扩展推理让模型在做出反应之前进行思考并产生一系列思维链,从而能够解决复杂逻辑问题。无监督学习提高了世界模型的准确性和直觉,GPT‑4.5提高了识别模式、建立联系和无需推理就能产生创造性见解的能力。

OpenAI表示,与OpenAI o1和OpenAI o3‑mini模型相比,GPT-4.5是一个更通用、天生更智能的模型。早期测试表明,与GPT‑4.5交互更自然。GPT‑4.5更广泛的知识基础、更强的追随用户意图能力和更高的“情商”,使它在提高写作、编程和解决实际问题等任务上有效。GPT‑4.5能更好地理解人类的意思,并以更细微的差别和“情商”来解释微妙的暗示或隐含的期望。

快思慢想研究院院长、原商汤智能产业研究院创始院长田丰表示,GPT-4.5的推出,印证了美国大模型继续走“大力出奇迹”的尺度定律路线,算力、数据、模型都是顶级配置,以更大的算力、更多的数据,训练出效果更好的模型,“GPT‑4.5的预训练阶段算力非常大,用了10倍的算力来做训练。”

“神仙”按月打架,重视技术储备

“今年大模型会出现你追我赶的节奏,OpenAI现在采取的策略像是 ‘领先半步’。”田丰表示。

在GPT-4.5推出前,OpenAI内部至少在迭代两个模型版本,即针对GPT-4.5和GPT-5进行测试、工程优化、产品化对齐等。“OpenAI有资金、人力、算力做双版本的储备,其他公司要跟上节奏,也必须做到。”他表示,在当前竞争周期越来越长的情况下,无论是国外的Anthropic,还是国内的DeepSeek,都需要有更多技术储备投入。

“头部大模型公司按季度更新模型版本,最慢100天,短的话30天,‘神仙打架’已经按月来打,一个季度就是一场巡回赛了。如果跟不上这个节奏,就要在产业链上找到自己的优势。”田丰表示,“大模型厂家如果不能每一两个月推出一个新版本,可能会憋大招,憋三五个月憋出一个好版本追上现在的大模型也是可以的。”

他认为,当前最值得关注的国外大模型是OpenAI的GPT-4.5、Anthropic的Claude 3.5、马斯克旗下AI公司xAI的Grok 3,尤其是三者间的逻辑推理能力对比更有价值。其中,Anthropic日前推出的混合推理模型Claude 3.7 Sonnet具有“系统一”和“系统二”两套系统,既可以快速回答用户问题,也可以针对复杂问题启动“系统二”的深度思考,思考时间会更长,就像人类一样。从这个角度看,Claude 3.7 Sonnet在架构的双系统层面具有一定的领先性和启发意义,“在数据和算力遇到瓶颈时,会把创新集中在模型架构层面,探索方法上的创新、工程化的创新、架构上的创新。”

田丰表示,GPT-4.5等模型将加速补全基础模型通用知识领域,增强复杂推理质量和情绪感知,基础模型负责高水平通用能力,AI应用负责行业逻辑。Grok3会在空间智能领域发力,加速具身智能体的“ChatGPT时刻”到来。垂直领域的专业模型也会成为中国大模型的竞技场,中国在机器人产量、使用规模方面更有优势。

庞大但昂贵

在对GPT4.5的性能给出了高度评价的同时,山姆·奥特曼也表示这是一个“庞大且昂贵”的模型。

据悉,调用GPT-4.5的API目前的输入价格为75美元/百万token,输出价格为150美元/百万token,不仅高于GPT以往的模型,也高于市场其他模型。以Claude 3.7为例,调用其API,输入百万token的收费为3美元,输出则为15美元。

跟国内模型更是不能比,DeepSeek-V3最近给出了错峰优惠政策,在凌晨时段,调用DeepSeek-V3的API输入百万token只需要0.25元,即便是非优惠时段也不过是0.5元;输出百万token的优惠价格是4元,标准时段价格为8元,定价均为人民币。

在业内人士看来,OpenAI的定价之所以如此之贵,一方面是其算力成本真的很高,另一方面也说海外市场和国内市场的定价策略遵循了不一样的逻辑,OpenAI仍然可以依赖技术优势获得更高的溢价。

田丰表示,OpenAI目前也面临GPU不够用的难题,GPT‑4.5推理成本高、算力开支大,导致用户使用昂贵,难以全民推广和使用。

OpenAI CEO山姆·奥特曼在社交媒体坦言,“我们真的很想同时为Pro用户和Plus用户推出,但我们已经发展得很快了,GPU也用完了。我们将在下周增加数以万计的GPU,向Plus用户推出服务。”ChatGPT Pro的月费是200美元。GPT‑4.5目前不支持ChatGPT中的语音模式、视频和屏幕共享等多模式功能。

Hugging Face工程师王铁震认为,OpenAI的定价策略之所以没有被DeepSeek“卷”到,是因为国内市场和海外市场原本就是不一样的定价策略。另有大模型从业人士认为,OpenAI仍然走的是“高服务定价-高企业估值”的业务逻辑,“追求技术快人一步,然后享受技术溢价”。

田丰认为,相对于美国企业的“大力出奇迹”,国内目前的大模型路线是以极致性价比实现更好的模型效果,“两边走得会越来越不一样,但最终都会拉到一个竞技场上去PK。”

在王铁震看来,国内市场“卷价格”已经遍布各行各业,相比之下,海外市场享有更高的利润,海外市场能够接受技术带来的溢价,这也是近年来中国企业集体出海的一个重要动力,但中国大模型企业要想走入海外市场,会面临和中国电动车等其他行业出海一样的挑战,这些挑战将不止于价格、技术和性能。

我国科学家近期取得一项研究成果,能够让动态无线充电更高效。其未来应用有望让无人机边飞边充电。相关成果近日发表于国际学术期刊《自然·通讯》。

西安电子科技大学电子工程学院李龙教授课题组在无线能量传输和无线定位领域取得突破性进展,构建了一种基于双频超表面的无线传能、感知定位与通信一体化原型系统,实现了自适应追踪的无线能量传输。在这一系统中,超表面不仅实现了精确的目标定位,还能根据实时变化的环境和目标,进行灵活的能量聚焦,实现跟踪式隔空输能。

与传统的无线充电方式相比,该技术具有显著的优势:能够支持多个终端设备在移动过程中进行高效的非接触式无线充电,例如运动中的无人机、智能机器人等,为其提供稳定、高效的电力供应。

据悉,该论文成果以西安电子科技大学为第一单位发表,电子工程学院博士生夏得校为论文第一作者,李龙教授和东南大学崔铁军院士为共同通讯作者。

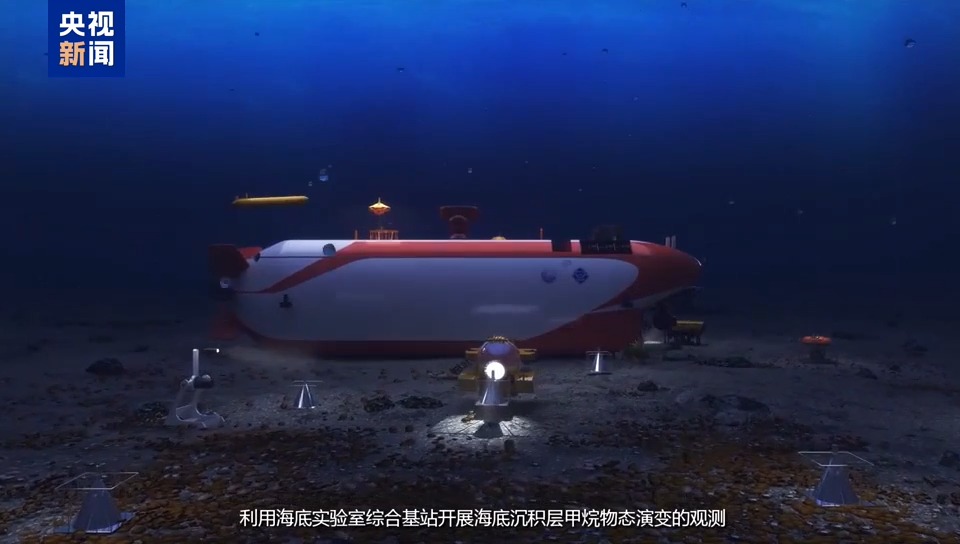

2月28日,国家重大科技基础设施“冷泉生态系统研究装置”在广州市全面启动建设。该设施由中国科学院南海海洋研究所牵头申报并承担建设,项目包含“海底实验室分总体”“保真模拟分总体”“保障支撑分总体”三部分。这也是世界首个2000米级坐底式可载人长期驻留的深海实验室。

冷泉装置采用“样地实验+陆地模拟,海陆协同、时空互换”的设计思想,计划用5年的时间,建设面向冷泉生态系统的深海载人驻守型海底实验室与陆基保真模拟设施相融合的国际领先研究装置,支撑冷泉生态系统发育、化能合成生物演替和甲烷物态演化及其环境效应研究。冷泉装置建成后,将为探索深海极端环境下的生命起源及可燃冰等深海资源的绿色开发等前沿基础研究和高新技术研发提供先进的平台支撑,成为我国在深海科学研究领域迈出的关键一步,服务“海洋强国”战略及“双碳”目标。

“冷泉”是指海底之下的甲烷、硫化氢和二氧化碳等气体在地质结构或压力变化驱动下,溢出海底进入海水的活动。而冷泉生态系统是指海洋生物利用海底冷泉渗出的化学物质为能源进行化能合成,发育成海底黑暗世界里独特的生态系统,具有黑暗、高压、低氧等理化特征,以可燃冰分解的甲烷为生源要素,通过化能合成作用而生生不息,被誉为“深海绿洲”。冷泉生态系统承载着地球深部碳循环的密码,是研究极端环境生命适应机制、探索新型生物资源的战略要地。开展冷泉生态系统研究是可燃冰等深海资源绿色开发与深海科学研究的最佳切入点。冷泉装置将为冷泉生态系统的研究提供全新的视角和技术手段,加速相关领域的科研进展。

计划用5年的时间,建成国际首个2000米级坐底式深海载人驻留实验室

冷泉装置总建设计划用5年的时间,建成国际首个2000米级坐底式深海载人驻留实验室,这也是世界首个面向海底冷泉系统的大科学装置,建成后将促进冷泉发育机制、极端生命演化过程、可燃冰的生态效应研究等海洋科学跨越式发展,推动深远海科技进步。